Under de senaste månaderna har det inom artificiell intelligens förts en hetsig debatt som utlösts av två inflytelserika forskningsrapporter som publicerats av Apple. Den första, illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic " (oktober 2024), och den andra, "Illusionen av att tänka" (juni 2025) ifrågasatte den påstådda resonemangsförmågan hos stora språkmodeller, vilket utlöste blandade reaktioner i branschen.

Som vi redan har analyserat i vår tidigare fördjupning om "Illusionen om framsteg: att simulera allmän artificiell intelligens utan att uppnå den", berör frågan om artificiell resonemang själva kärnan i vad vi anser vara intelligens hos maskiner.

Apple-forskare genomförde en systematisk analys av Large Reasoning Models (LRM) - de modeller som genererar detaljerade resonemang innan de ger ett svar. Resultaten var överraskande och, för många, alarmerande.

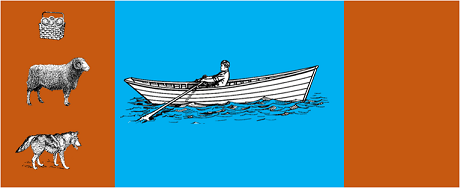

I studien utsattes de mest avancerade modellerna för klassiska algoritmiska pussel som t.ex:

Resultaten visade att även små förändringar i problemformuleringen leder till betydande variationer i prestanda, vilket tyder på en oroande svaghet i resonemanget. Som rapporterats i AppleInsider-täckning"minskar prestandan för alla modeller när endast de numeriska värdena i GSM-Symbolic benchmark-frågorna ändras".

Svaret från AI-gemenskapen lät inte vänta på sig. Alex Lawsen från Open Philanthropy, i samarbete med Claude Opus från Anthropic, publicerade en detaljerad motbevisning med titeln "Illusionen av att tänka".där han ifrågasatte metoderna och slutsatserna i Apple-studien.

När Lawsen upprepade testerna med alternativa metoder - och bad modellerna att generera rekursiva funktioner istället för att lista alla drag - blev resultaten dramatiskt annorlunda. Modeller som Claude, gemini och GPT löste korrekt Tower of Hanoi-problem med 15 poster, långt bortom den komplexitet där Apple rapporterade noll framgångar.

Gary Marcusen långvarig kritiker av LLM:s resonemangsförmåga, tog Apples resultat som en bekräftelse på sin 20-åriga avhandling. Enligt Marcus fortsätter civilingenjörer att kämpa med "distribution shift" - förmågan att generalisera bortom utbildningsdata - samtidigt som de är "bra på att lösa problem som redan har lösts".

Diskussionen har också spridit sig till specialiserade grupper som t.ex. LocalLlama på Redditdär utvecklare och forskare diskuterar de praktiska konsekvenserna för modeller med öppen källkod och lokal implementering.

Denna debatt är inte enbart akademisk. Den har direkta konsekvenser för:

Som framhävts i flera tekniska insikterfinns det ett ökande behov av hybridmetoder som kombinerar:

Trivialt exempel: en AI-assistent som hjälper till med bokföringen. Språkmodellen förstår när du frågar "hur mycket har jag spenderat på resor den här månaden?" och extraherar de relevanta parametrarna (kategori: resor, period: den här månaden). Men SQL-frågan som söker i databasen, beräknar summan och kontrollerar de skattemässiga begränsningarna? Det görs av deterministisk kod, inte av den neurala modellen.

Det undgick inte observatörerna att Apple-dokumentet publicerades strax före WWDC, vilket väcker frågor om de strategiska motiven. Som denanalys av 9to5Mac, "tidpunkten för Apple-papperet - precis före WWDC - höjde några ögonbryn. Var detta en milstolpe för forskningen eller ett strategiskt drag för att ompositionera Apple i det bredare AI-landskapet?"

Debatten som utlöstes av Apples papper påminner oss om att vi fortfarande befinner oss i ett tidigt skede när det gäller att förstå artificiell intelligens. Som påpekats i vår tidigare artikelär skillnaden mellan simulering och autentiskt resonemang fortfarande en av vår tids mest komplexa utmaningar.

Den verkliga lärdomen är inte huruvida jurister kan "resonera" i ordets mänskliga bemärkelse, utan snarare hur vi kan bygga system som utnyttjar deras styrkor och samtidigt kompenserar för deras begränsningar. I en värld där AI redan håller på att förändra hela sektorer är frågan inte längre om dessa verktyg är "smarta", utan hur de ska användas på ett effektivt och ansvarsfullt sätt.

Framtiden för AI i företag kommer förmodligen inte att ligga i ett enda revolutionerande tillvägagångssätt, utan i en intelligent orkestrering av flera kompletterande tekniker. Och i det här scenariot blir förmågan att kritiskt och ärligt utvärdera våra verktygs kapacitet en konkurrensfördel i sig.

Senaste utvecklingen (januari 2026)

OpenAI släpper o3 och o4-mini: Den 16 april 2025 släppte OpenAI o3 och o4-mini, de mest avancerade resonemangsmodellerna i o-serien. Dessa modeller kan nu använda verktyg på ett agentivt sätt och kombinera webbsökning, filanalys, visuellt resonemang och bildgenerering. o3 har satt nya rekord på benchmark som Codeforces, SWE-bench och MMMU, medan o4-mini optimerar prestanda och kostnader för högvolymiga resonemangsuppgifter. Modellerna visar förmåga att "tänka med bilder" genom att visuellt omvandla innehåll för mer djupgående analyser.

DeepSeek-R1 skakar om AI-branschen: I januari 2025 släppte DeepSeek R1, en öppen källkodsmodell för resonemang som uppnådde prestanda jämförbar med OpenAI o1 till en utbildningskostnad på endast 6 miljoner dollar (jämfört med hundratals miljoner för västerländska modeller). DeepSeek-R1 visar att resonemangskapaciteten kan stimuleras genom ren förstärkningsinlärning, utan behov av antecknade mänskliga demonstrationer. Modellen blev den mest populära gratisappen på App Store och Google Play i dussintals länder. I januari 2026 publicerade DeepSeek en 60-sidig artikel som avslöjar hemligheterna bakom träningen och öppet medger att tekniker som Monte Carlo Tree Search (MCTS) inte fungerade för allmän resonemang.

Anthropic uppdaterar Claudes "konstitution": Den 22 januari 2026 publicerade Anthropic en ny konstitution på 23 000 ord för Claude, där man gick från ett regelbaserat till ett principbaserat tillvägagångssätt. Dokumentet blir det första ramverket från ett stort AI-företag som formellt erkänner möjligheten till medvetande eller moralisk status hos AI, och bekräftar att Anthropic bryr sig om Claudes "psykologiska välbefinnande, självkänsla och välmående".

Debatten intensifieras: En studie från juli 2025 har replikerat och förfinat Apples riktmärken och bekräftat att LRM fortfarande uppvisar kognitiva begränsningar när komplexiteten ökar måttligt (cirka 8 skivor i Hanoi-tornet). Forskarna har visat att detta inte bara beror på utgångsbegränsningar, utan också på verkliga kognitiva begränsningar, vilket understryker att debatten långt ifrån är avslutad.

För insikter i din organisations AI-strategi och implementering av robusta lösningar finns vårt team av experter tillgängliga för skräddarsydda konsultationer.